반도체 데이터 분석 스터디 29기 1회

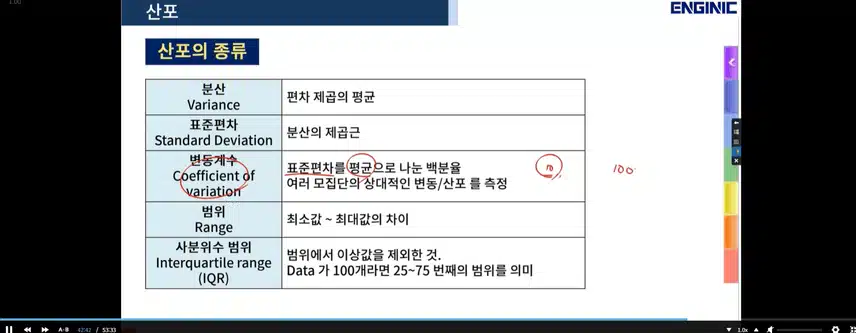

이번 강의자료를 통해 확률분포와 통계적 추정의 기본 개념을 배웠다. 특히 정규분포, 이항분포, 포아송분포, t-분포, 카이제곱분포, F-분포 등의 다양한 확률분포와 각 분포의 기대값과 분산에 대해 체계적으로 이해할 수 있었다.

정규분포는 반도체 공정에서 공정 편차 분석에 가장 많이 사용되는 분포로, 예를 들어 DRAM의 Latency가 10ns ±2ns인 경우와 같은 스펙 표기에 그대로 적용된다. 또한 Z-score 표준화를 통해 분포를 단순화하는 기법은 실제 데이터 분석에서 필수적인 도구임을 알게 되었다.

이항분포와 포아송분포는 결함 발생 확률이나 희귀 이벤트 분석에 활용된다. 반도체에서는 웨이퍼당 결함 수(D0 level)를 분석할 때 포아송분포를 많이 사용한다. 이번 강의에서는 기대값과 분산의 계산식을 반복적으로 다루면서, 확률적 사건의 평균적 행동을 예측하는 방법을 배웠다.

또한 표본평균의 분포와 t-분포, 카이제곱분포, F-분포를 배움으로써 공정 변동성 검증이나 공정간 비교 검정을 어떻게 진행하는지 이해할 수 있었다. 예를 들어, 두 공정의 불량률 차이를 검증할 때 F-검정을 사용하고, 수율 차이를 검증할 때 t-검정을 사용한다.

통계적 사고는 반도체 산업에서 매우 중요하다. 공정 설계나 품질 검증에서 발생하는 데이터의 해석과 판단을 위해 이번에 배운 개념들이 필수적으로 사용된다. 특히, **DFM(Design For Manufacturability)**에서 설계의 허용오차를 잡을 때, 공정변수의 분포와 통계적 특성을 고려하는 것이 매우 중요하다.

반도체 분야는 나노 스케일에서 공정의 미세한 편차도 제품의 품질에 큰 영향을 준다. 이번 통계 강의는 단순한 수학적 기법이 아니라, 실제 반도체 공정 관리와 품질보증에서 바로 적용 가능한 실질적인 도구라는 점을 느꼈다.

앞으로 반도체 공정설계나 공정 데이터 분석 업무를 하게 된다면, 공정의 변동성을 수치적으로 해석하고, 불량률 예측 및 수율 개선 방안 도출에 이번에 배운 확률과 통계 기법을 적극적으로 활용할 계획이다. 나아가 Minitab, JMP, Python 통계 패키지 등과 연계하여 데이터 기반 공정 최적화를 진행하고 싶다.

#엔지닉 #반도체데이터분석

작성자 우아한악어2972

신고글 반도체 데이터 분석 스터디 29기 1회

- 욕설/비하 발언

- 음란성

- 홍보성 콘텐츠 및 도배글

- 개인정보 노출

- 특정인 비방

- 기타

허위 신고의 경우 서비스 이용제한과 같은

불이익을 받으실 수 있습니다.